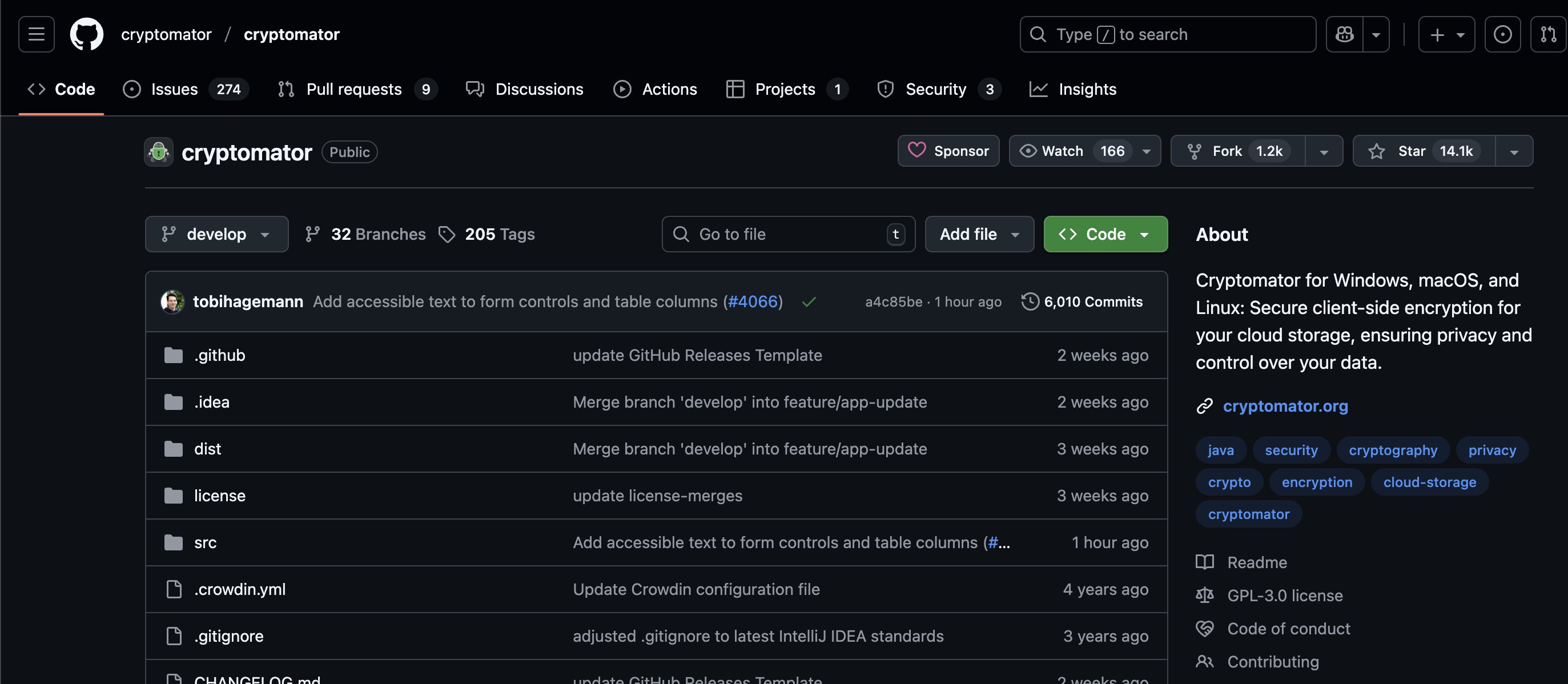

VSCode + Ollama + Qwen3

VSCode + Ollama + Qwen3

Carkree本文简单记录VSCode+Ollama+Qwen3的配置

1. 安装Ollama并启动

Ollama 是一个开源的大型语言模型(LLM)平台,旨在让用户能够轻松地在本地运行、管理和与大型语言模型进行交互。它提供了便捷的模型管理、丰富的预建模型库,支持文本生成、翻译、代码编写、问答等多种自然语言处理任务。Ollama 允许用户在本地机器上拉取、管理和运行大模型,并提供多种访问方式,包括本地 CLI 和 HTTP 接口

在Mac上,直接使用homebrew安装ollama:

1 | brew install ollama |

接着,使用命令启动:

1 | brew services start ollama |

2. 拉取Qwen3

我的电脑是16GB内存的Macbook M2,所以选择qwen3:8b模型

1 | ollama run qwen3:8b |

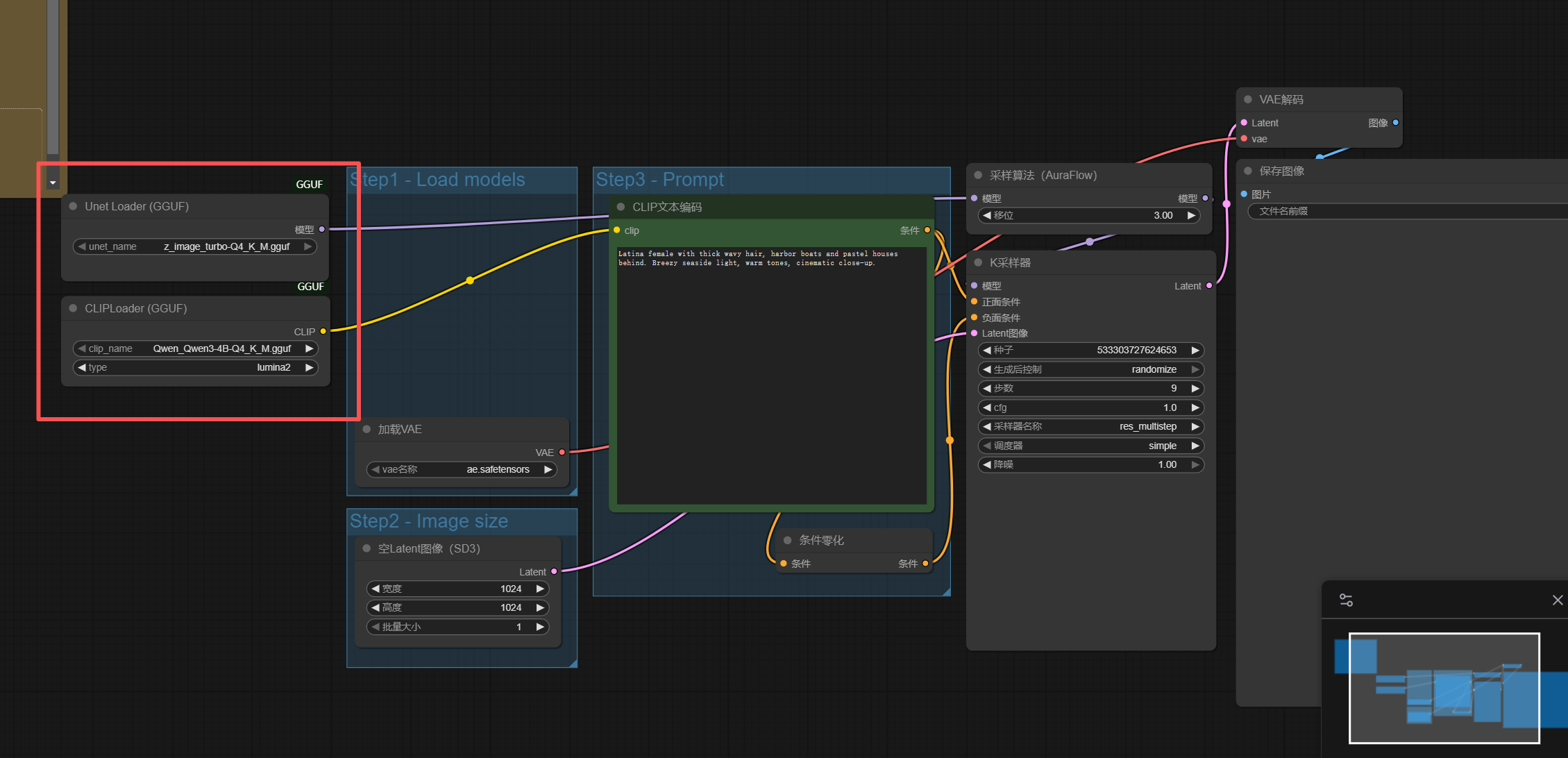

3. 配置VSCode

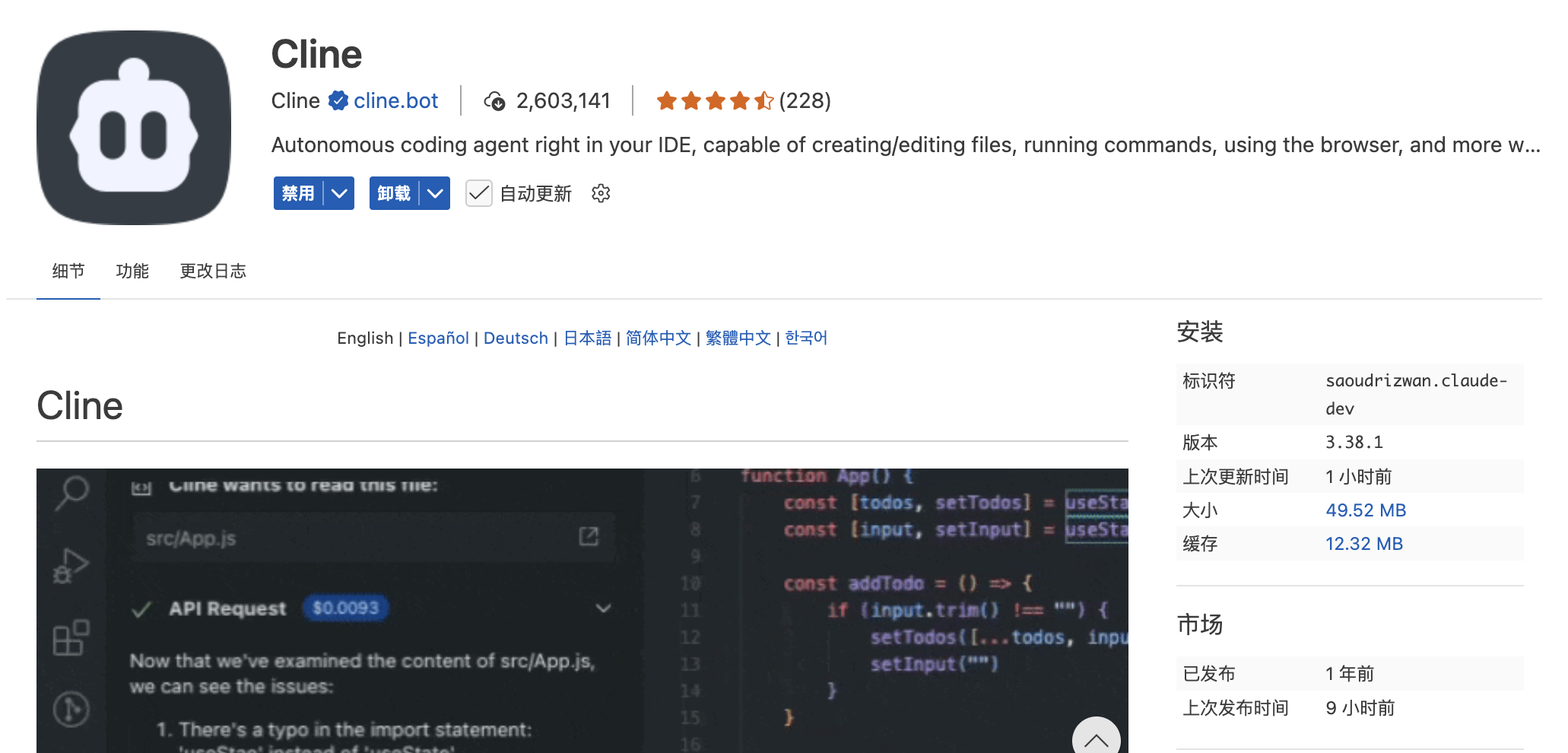

安装Cline插件

接着,进行配置:

- API Provider:

Ollama - Model:

qwen3:8b

其他均默认即可

在侧边栏点击Cline的icon,进入Cline界面,就可以对话了。启动的时候确保ollama在运行即可

结语

经过测试,发现速度太慢了,还是别用了,就当玩了。可以安装一个通义灵码的插件,目前免费使用满血版qwen3模型.

本文使用CC BY-NC-SA 4.0协议进行许可

评论

匿名评论隐私政策

✅ 你无需删除空行,直接评论以获取最佳展示效果